在这个数据为王的时代,爬虫技术就像是我们在互联网海洋中的探险船,帮助我们搜集宝贵的信息宝藏。但你知道吗?在爬虫航行的过程中,IP代理就像是它的“变形金刚”装备,能让爬虫在遭遇封锁时瞬间“变身”,继续前行。今天,咱们就来聊聊爬虫怎么使用IP代理,让你的爬虫之路畅通无阻!

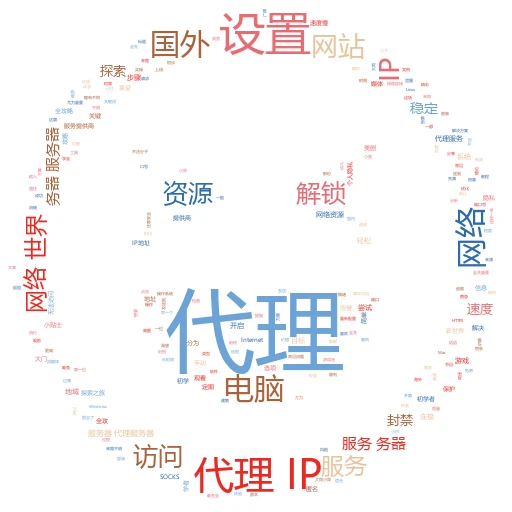

一、IP代理:爬虫界的“隐身斗篷”

想象一下,你是一名网络侦探,正在追踪某个神秘网站的数据。但网站似乎有所警觉,一旦发现你的IP地址频繁访问,就会把你列入黑名单。这时,IP代理就像是你的“隐身斗篷”,它能让你每次访问都换一个“身份”(即不同的IP地址),从而避开封锁。

实例讲解:比如,你想爬取一个电商网站上的商品信息,但网站设置了反爬虫机制。这时,你可以使用一个IP代理池,每次请求都随机选择一个代理IP,这样网站就无法准确追踪到你的真实IP,你的爬虫就能顺利完成任务。

二、选择IP代理:品质决定成败

既然IP代理这么重要,那我们该怎么选择呢?这里有几个关键点:

稳定性:代理IP要稳定,不能经常掉线或响应慢,否则会影响爬虫的效率。

匿名性:最好选择高匿名代理,这样网站无法识别出你是通过代理访问的。

速度:代理IP的访问速度要快,否则爬虫爬取数据时会非常耗时。

数量:代理IP的数量要多,这样才能满足大规模爬虫的需求。

案例分析:小明在爬取一个社交网站的用户数据时,选择了几个免费的代理IP。结果,这些代理IP要么不稳定,要么速度慢,导致他的爬虫任务频繁失败。后来,他换成了一个付费的IP代理池,问题迎刃而解,爬虫效率大大提升。

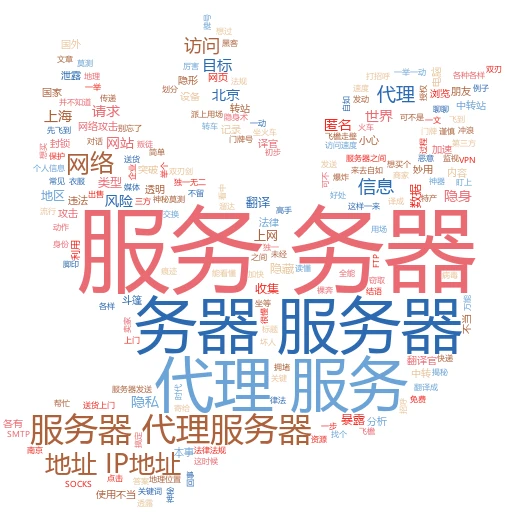

三、配置IP代理:让爬虫“变身”

选好了IP代理,接下来就该配置爬虫了。以Python的requests库为例,配置IP代理非常简单。

代码示例:

import requests proxies = { 'http': 'http://your-proxy-ip:port', 'https': 'https://your-proxy-ip:port', } response = requests.get('http://example.com', proxies=proxies) print(response.text) 在上面的代码中,proxies字典存储了代理IP的信息,requests.get方法通过proxies参数使用这些代理IP发送请求。

实战技巧:为了提高爬虫的稳定性和效率,你可以使用代理IP池,每次请求时从池中随机选择一个代理IP。同时,你还可以设置代理IP的失效机制,当某个代理IP无法访问或响应超时时,就将其从池中移除。

四、应对反爬虫机制:IP代理的“组合拳”

网站的反爬虫机制越来越复杂,单靠IP代理可能不够用。这时,我们可以结合其他技巧,打出一套“组合拳”。

随机User-Agent:每次请求时随机选择一个User-Agent,模拟不同浏览器的访问行为。

随机请求头:除了User-Agent,还可以随机设置其他请求头信息,如Accept、Accept-Language等。

控制访问频率:合理设置爬虫的访问频率,避免对网站造成过大压力。

使用Cookies:有些网站需要登录才能访问数据,这时你可以使用Cookies来模拟登录状态。

实例分享:小红在爬取一个新闻网站时,发现单纯使用IP代理仍然会被封锁。于是,她结合了随机User-Agent和随机请求头技巧,同时控制了访问频率。结果,她的爬虫成功绕过了反爬虫机制,顺利爬取了数据。

五、总结与启示

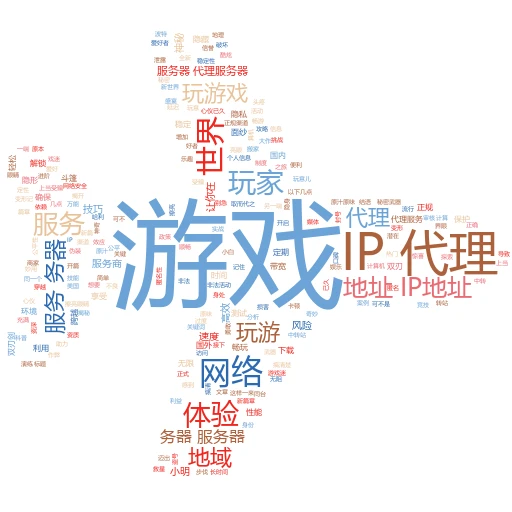

通过上面的讲解和案例,相信你已经掌握了爬虫使用IP代理的基本方法和技巧。但记住,爬虫技术是一把双刃剑,既要合理利用它获取有价值的数据,也要遵守法律法规和网站的robots协议,避免触碰红线。

在这个数据爆炸的时代,让我们用智慧和技巧去挖掘数据的宝藏吧!愿你的爬虫之路越走越宽,收获满满!

关键词标签:爬虫技术、IP代理、反爬虫机制

自媒体标题推荐:

🔍 爬虫高手必备!轻松玩转IP代理,数据任你采!

🚀 揭秘!爬虫如何穿上“隐身斗篷”,突破封锁采集数据?