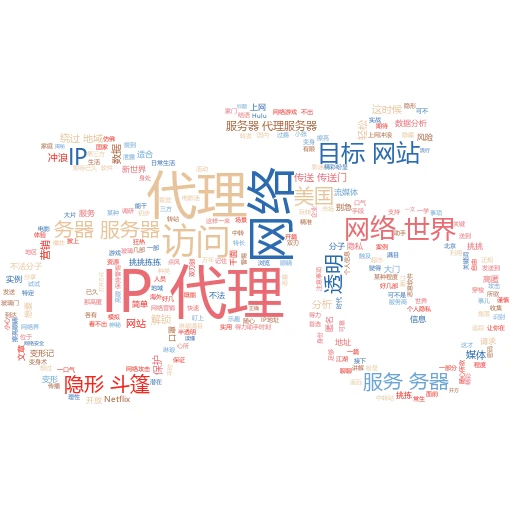

在这个数据为王的时代,爬虫技术就像一把钥匙,为我们打开了互联网这座宝藏库的大门。但你知道吗?在爬虫的探险之旅中,IP代理就像是那件不可或缺的“隐形斗篷”,让你在数据的海洋里自由穿梭而不被限制。今天,咱们就来聊聊如何在爬虫中使用IP代理,让你的数据抓取之路更加畅通无阻。

一、IP代理:爬虫界的“变脸大师”

想象一下,你是一名侦探,在调查一起网络案件。为了防止被目标网站发现你的身份,你是不是得时不时换个面貌出现?IP代理就是这个作用,它能让你的爬虫在访问网站时,每次都用不同的IP地址,就像是戴上了不同的面具,大大降低了被封禁的风险。

实例讲解:假设你要抓取某个电商网站的商品信息,直接用同一个IP频繁访问,很快就会被网站的安全系统识别为异常行为,然后给你来个“闭门羹”。但如果你使用了IP代理,每次请求都换一个IP,网站就难以追踪到你的真实身份,抓取工作就能顺利进行。

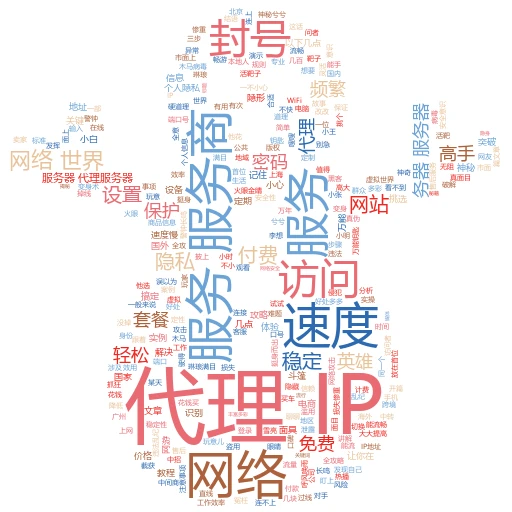

二、挑选代理:质量决定成败

IP代理可不是随便找个就能用的,质量参差不齐,选对了事半功倍,选错了可能让你事倍功半。那么,什么样的IP代理才是好代理呢?

案例分析:小明是个爬虫新手,他随便在网上找了个免费的IP代理服务。结果,抓取数据时速度奇慢无比,还经常遇到请求失败的情况。后来,他改用了一家付费的高质量代理服务商,速度提升了数倍,成功率也大幅提高。原来,高质量的代理通常拥有稳定的网络连接、较快的响应速度以及较低的被封禁风险。

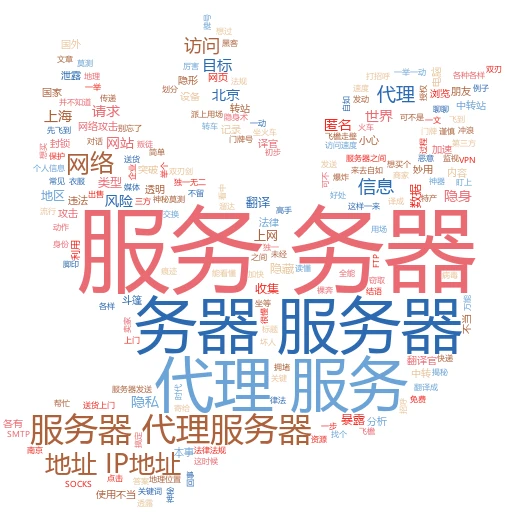

三、配置代理:实战操作手册

选好了代理,接下来就是如何在爬虫中配置了。不同的编程语言和环境,配置方法会有所不同,但基本原理是相通的。

以Python为例:假设你使用的是requests库,配置IP代理非常简单。只需在请求头中加入proxies参数,指定代理服务器的地址和端口即可。记得,代理类型(HTTP、HTTPS等)也要匹配正确哦。

import requests proxies = { 'http': 'http://your-proxy-server:port', 'https': 'https://your-proxy-server:port', } response = requests.get('http://example.com', proxies=proxies) print(response.text)

import requests proxies = { 'http': 'http://your-proxy-server:port', 'https': 'https://your-proxy-server:port', } response = requests.get('http://example.com', proxies=proxies) print(response.text) 小贴士:别忘了,代理服务器也是需要认证的,有的代理服务商会提供用户名和密码。这时候,你就需要在proxies参数中加入认证信息,通常是以http://username:password@proxy-server:port的形式。

四、维护代理池:持久战的智慧

使用单个或少量代理很容易遇到失效的情况,毕竟没有哪个代理能永远不被封禁。因此,建立一个动态更新的代理池,是实现长期稳定抓取的关键。

实战技巧:你可以定期从可靠的代理网站上抓取新的代理IP,然后验证它们的有效性,将有效的代理存入数据库或文件中。在爬虫运行时,从代理池中随机选取一个使用,如果请求失败或响应时间过长,就标记该代理为失效,并从池中移除。这样,你的爬虫就能始终保持高效稳定的运行状态。

五、合规使用:别忘了法律的边界

最后,虽然IP代理让爬虫变得更加灵活强大,但别忘了合规使用的重要性。未经允许擅自抓取他人网站数据是违法的,尊重网站的使用条款和隐私政策,是每位爬虫开发者应有的素质。

思考时刻:在追求数据的同时,我们是否也应该思考,这些数据的使用是否合法、合理?在技术的道路上,保持敬畏之心,才能走得更远。

文章标签关键词:爬虫技术、IP代理、数据抓取

自媒体标题建议:

🕵️♂️爬虫高手秘籍:如何巧妙利用IP代理,在数据海洋里“隐身”前行?

🚀解锁爬虫新技能!用IP代理,让你的数据抓取之路畅通无阻!