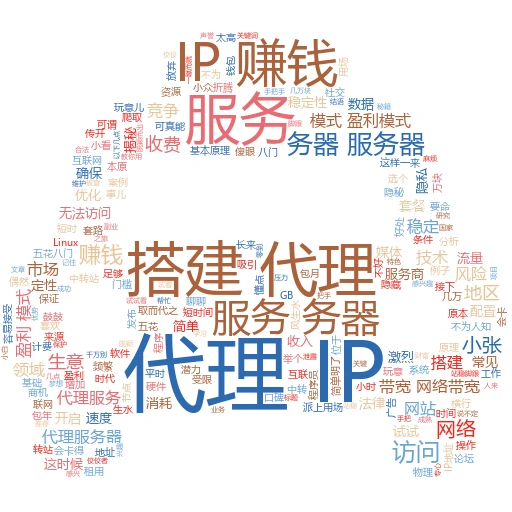

抓代理IP不再是难题,小白也能轻松上手

在这个信息爆炸的时代,网络爬虫、数据分析、甚至是日常的网络冲浪,都可能需要用到代理IP。但很多新手面对这个陌生的词汇时,往往一头雾水,不知所措。别担心,今天咱们就来聊聊怎么抓代理IP,让你从零基础也能变成抓IP的小能手!

一、代理IP是啥?为啥要用它?

代理IP,简单来说,就是一个中间商的角色。你的网络请求先发给代理服务器,再由代理服务器帮你发到目标网站。这样做的好处多多,比如可以隐藏你的真实IP,防止被目标网站封禁;还能加快访问速度,尤其是当你访问的网站在国外时。

举个栗子,就像你想买件国外的名牌衣服,但直接去买可能关税高、物流慢。这时,你找了个代购,他帮你从国外买,再寄给你,既省心又省力。代理IP就是网络世界里的这个“代购”。

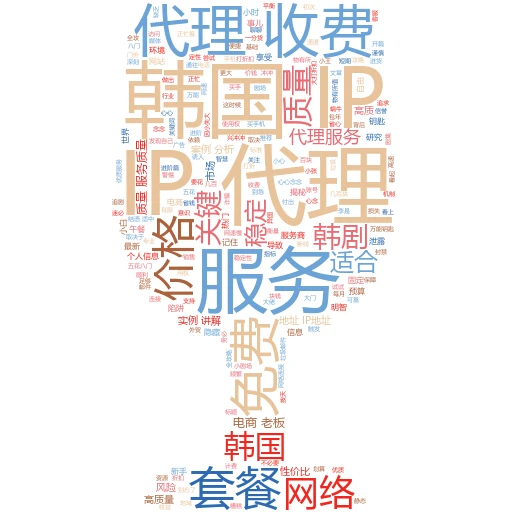

二、免费代理IP?小心陷阱!

网上有很多免费的代理IP网站,看起来很方便,但实则暗藏玄机。很多免费代理IP都是别人用过的,速度慢、稳定性差,还可能被目标网站标记为恶意IP。这就像你去超市拿免费试吃的糖果,虽然不要钱,但味道可能一言难尽。

所以,如果你不是只是偶尔用一下,还是建议你考虑付费的代理IP服务。虽然要钱,但胜在速度快、稳定性好,还能保证你的网络安全。

三、自己动手,丰衣足食——抓取代理IP

既然知道了代理IP的好处,那咱就来说说怎么抓。这里介绍一个简单的方法,用Python和BeautifulSoup库来抓取。

案例实操:

首先,你得安装Python和BeautifulSoup库。这个网上有很多教程,就不赘述了。

然后,找一个公开的代理IP网站作为目标。比如这个网站,上面有很多免费的代理IP,虽然质量可能不高,但胜在数量多,适合练手。

接下来,用Python发送请求到这个网站,获取网页源码。再用BeautifulSoup解析源码,提取出代理IP的信息。

import requests from bs4 import BeautifulSoup # 目标网站URL url = 'http://example.com/proxy-list' # 请替换为实际网站 # 发送请求,获取网页源码 response = requests.get(url) html = response.text # 用BeautifulSoup解析源码 soup = BeautifulSoup(html, 'html.parser') # 提取代理IP信息,这里假设代理IP信息在<td>标签里 proxies = [] for td in soup.find_all('td'): # 这里只是示例,实际情况可能需要根据网页结构来调整 if 'IP' in td.text or 'PORT' in td.text: # 提取IP和端口,并添加到列表中 # 注意:这里只是简单示例,实际提取可能需要更复杂的逻辑 proxies.append(td.text.strip()) # 打印提取到的代理IP信息 for proxy in proxies: print(proxy)

url = 'http://example.com/proxy-list' # 请替换为实际网站 # 发送请求,获取网页源码 response = requests.get(url) html = response.text # 用BeautifulSoup解析源码 soup = BeautifulSoup(html, 'html.parser') # 提取代理IP信息,这里假设代理IP信息在<td>标签里 proxies = [] for td in soup.find_all('td'): # 这里只是示例,实际情况可能需要根据网页结构来调整 if 'IP' in td.text or 'PORT' in td.text: # 提取IP和端口,并添加到列表中 # 注意:这里只是简单示例,实际提取可能需要更复杂的逻辑 proxies.append(td.text.strip()) # 打印提取到的代理IP信息 for proxy in proxies: print(proxy) 注意:上面的代码只是示例,实际使用时需要根据目标网站的结构来调整。而且,抓取代理IP可能会违反目标网站的使用协议,所以请谨慎操作,别给自己惹麻烦。

四、验证代理IP,选出精品

抓取到的代理IP不一定都能用,所以还需要验证。你可以用Python的requests库,通过代理IP发送请求到某个网站,看看是否能成功获取到内容。能获取到的,就是可用的代理IP;获取不到的,就是不可用的。

五、别忘了隐私和安全

在使用代理IP时,一定要注意隐私和安全。别让你的个人信息泄露出去,也别被恶意IP给黑了。尽量选择信誉好的代理IP服务商,别贪小便宜吃大亏。

结语:

怎么样?看完这篇文章,你是不是对怎么抓代理IP有了更深入的了解呢?记住,理论知识固然重要,但动手实践才是检验真理的唯一标准。所以,别犹豫了,赶紧打开电脑,自己动手试试吧!相信你一定能成为抓IP的小能手!

关键词标签:

代理IP

Python抓取

网络安全

自媒体标题建议:

🔥小白必看!从零开始学抓代理IP,轻松搞定网络爬虫!

💡代理IP不再神秘!一文教你如何抓取、验证,秒变网络高手!