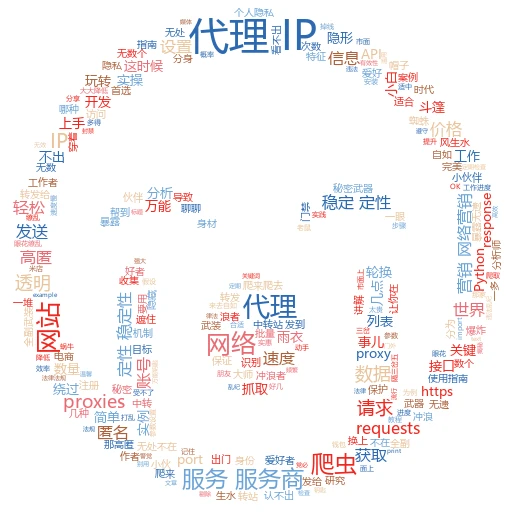

requests代理IP怎么用?看这篇就够了!

开篇小故事:爬虫小白的困扰

想象一下,你是一名刚入门的数据爬虫爱好者,每天乐此不疲地在网络上抓取各种有趣的数据。但有一天,你突然发现,不管怎么抓,总是被目标网站无情地拒绝访问,甚至IP地址都被封杀了。这时候,你心里是不是有点小崩溃?别急,今天咱们就来聊聊如何用requests库轻松搞定代理IP,让你的爬虫之路畅通无阻!

一、代理IP是啥?为啥要用它?

代理IP,简单来说,就是一个中间商的角色。当你想要访问某个网站时,不是直接过去,而是先通过一个代理服务器,再由这个服务器去访问目标网站。这样做的好处多多,比如可以隐藏你的真实IP地址,防止被封杀;还可以加快访问速度,尤其是在访问国外网站时。

实例讲解:

比如你想抓取某个电商网站的数据,但你的IP因为频繁访问被封了。这时候,你就可以用一个代理IP来代替你的真实IP去访问,网站看到的只是代理服务器的IP,而不是你的。这样一来,你就可以继续愉快地抓数据啦!

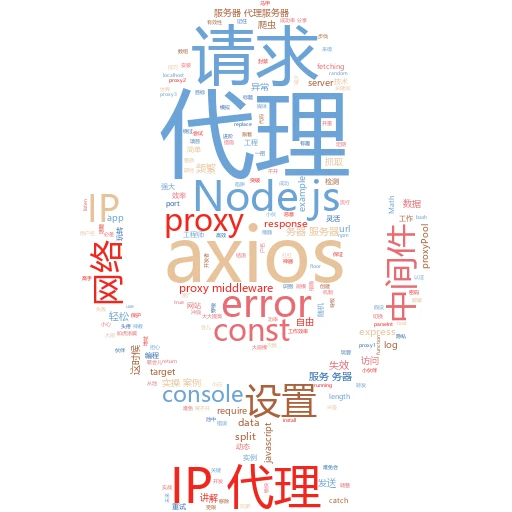

二、requests库与代理IP的结合

requests是一个简单易用的HTTP库,用它来发送网络请求简直不要太方便。而要在requests中使用代理IP,也只需要简单几步。

实际操作:

首先,你需要找到一个可靠的代理IP提供商,获取一些可用的代理IP地址和端口。然后,在发送请求时,将这些信息作为参数传递给requests即可。

import requests proxies = { 'http': 'http://your-proxy-ip:port',  'https': 'https://your-proxy-ip:port', } url = 'http://example.com' response = requests.get(url, proxies=proxies) print(response.text)

'https': 'https://your-proxy-ip:port', } url = 'http://example.com' response = requests.get(url, proxies=proxies) print(response.text) 这段代码就是最基本的在requests中使用代理IP的例子。注意,这里的your-proxy-ip:port需要替换成你实际获取的代理IP地址和端口。

三、代理IP的分类与选择

代理IP有很多种,按匿名程度可以分为透明代理、匿名代理和高匿代理;按来源可以分为免费代理和付费代理。那么,我们该如何选择呢?

实例分析:

透明代理:这种代理会暴露你的真实IP地址,基本没啥用,除非你就是想让人知道你在用代理。

匿名代理:虽然隐藏了你的真实IP,但网站还是能通过一些手段识别出来。

高匿代理:这种代理最隐蔽,网站完全无法知道你的真实IP地址。

至于免费代理和付费代理,那就更不用说了。免费代理通常不稳定、速度慢、容易被封,而付费代理则相对稳定、速度快、可用率高。所以,如果你的爬虫任务比较重要,还是建议选择付费代理。

四、如何应对代理IP被封?

即使你用了代理IP,还是有可能被封。毕竟,代理IP也不是万能的。那么,我们该如何应对呢?

实战技巧:

轮换代理IP:不要一直用一个代理IP去访问,要定期更换。

限制访问频率:不要一下子发送太多请求,要模拟人类的访问习惯。

使用User-Agent:模拟不同的浏览器和设备去访问,增加伪装性。

这些技巧都可以在一定程度上降低被封的风险。当然,最重要的还是遵守网站的robots协议和法律法规,不要恶意抓取数据。

五、总结与展望

好了,说了这么多,相信你已经对如何在requests中使用代理IP有了比较深入的了解。但记住,这只是爬虫技术中的一小部分。想要成为一名真正的爬虫高手,还需要学习更多的知识,比如正则表达式、BeautifulSoup、Selenium等等。

不过别担心,只要你保持好奇心和学习热情,相信很快就能掌握这些技能。到时候,你就可以在数据的海洋里自由遨游了!

自媒体流行标题:

爬虫小白必看!requests代理IP使用全攻略!

轻松搞定!requests中如何巧妙利用代理IP抓取数据?